מהו לדעתך האיום הגדול ביותר על עתיד האנושות? שינויי אקלים? מלחמה גרעינית? מגיפה עולמית? כולם מעוררים דאגה, אבל אני מאמין שאחד הסיכונים הגדולים ביותר הוא בעצם AI סופר אינטליגנטי.

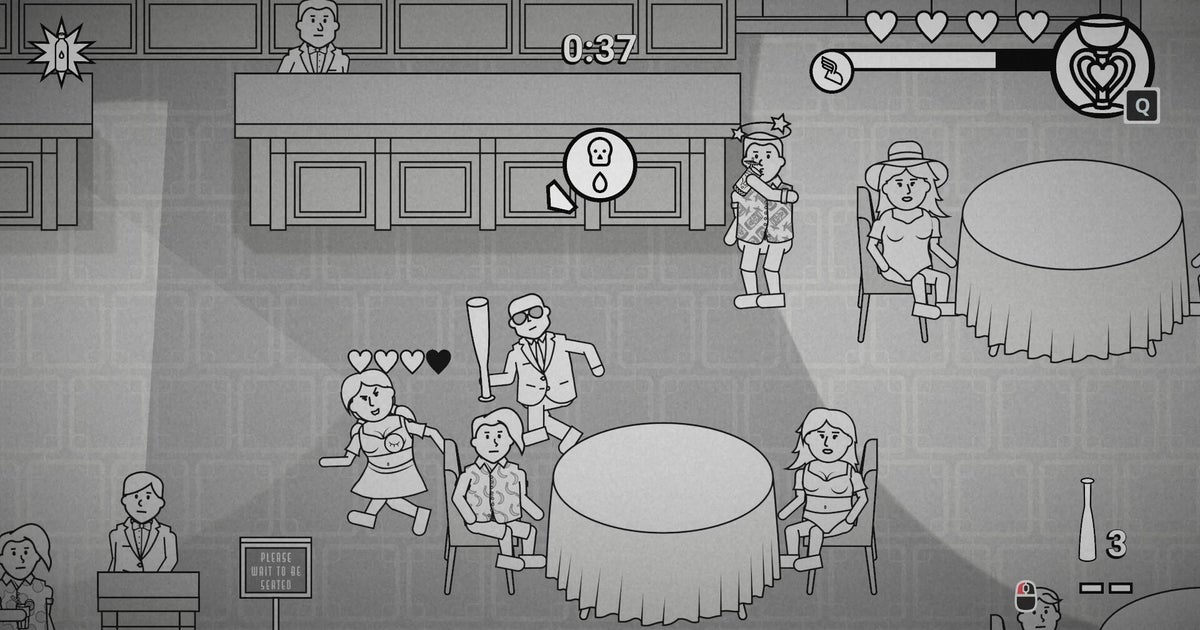

ייתכן שתצטרך לשכנע את זה, וזו הסיבה שחוקרים במרכז לחקר הסיכון הקיומי של אוניברסיטת קיימברידג'עשו מודעֲבוּרציוויליזציה Vשמציגה בינה מלאכותית אפוקליפטית. התעלם מהצורך הדוחק במחקר בטיחות AI, וזה נגמר.

ניסיתי את זה בשבוע שעבר, וביקשתי לענות על שתי שאלות. האם הוא מתאר במדויק את הסיכונים הכרוכים בהתפתחות של ישות דמוית אל? והאם זה כיף?

המוד סובב סביב החלפת מצב הניצחון הרגיל במדע. במקום לשגר חללית לאלפא קנטאורי, עליך לצבור מספר מסוים של נקודות מחקר בינה מלאכותית. מבנים מסוימים מייצרים את המחקר הזה - אבל אתה לא יכול לבנות סתם כך. עבור כל מרכז מחקר שקיים על פני המפה, גם מונה סיכון בינה מלאכותית יתקתק. אם זה יגיע ל-800, כולם מפסידים: האנושות כולה נכנעת לאינטליגנציה-על חסרת הגבלה המעוותת את העולם למטרה המעוותת שלה.

אם זה נשמע לך כתרחיש בלתי אפשרי, אז אתה בדיוק מסוג האנשים שה-CSER מקווה שיבדוק את המוד. הרעיון הוא לא רק להזהיר אנשים על האפשרות שבינה מלאכותית סופר אינטליגנטית יכולה להיות איום שצריך לטפל בו, אלא להמחיש כיצד המצב הגיאופוליטי של כדור הארץ עלול להחמיר את האיום הזה. לדוגמה, אחת מטכנולוגיות המשחק המאוחרות החדשות היא בינה מלאכותית צבאית: פיתוח שלה היה נותן לי יתרון צבאי, אבל מוסיף משמעותית למונה הסיכונים.

הדוגמה הזו גם מראה מדוע אני לא חושב שהמוד מצליח כחינוך או בידור. עוד מעט אתעמק בצד התקשורת המדע של הדברים, אבל לעת עתה אסתכל על זה כמשחק. הבעיה העיקרית היא שכל השינויים שמגיעים עם המודים הם תוספות של משחק מאוחר - והמשחק המאוחר הוא ללא ספק החלק החלש ביותר של Civ.

כמו במשחקי 4X רבים, ברגע שאתה מתחיל להתקדם ב-Civ אתה הופך לרכבת בלתי ניתנת לעצירה. גיליתי שרמת הטכנולוגיה שלי עד כה עלתה על זו של השכנים שלי, שה-AI הצבאי לא פיתה אותי במעט. בדיוק מאותה סיבה, לא הרגשתי שום לחץ לבנות מספר לא בטוח של מרכזי מחקר - יכולתי פשוט לחכות עד שאוכל להקים מרכזי בטיחות, שמפחיתים את הקצב שבו מד הסיכון מתקתק.

למען ההגינות, הרבה מזה מסתכם בקושי ששיחקתי עליו. תמיד מצאתי שהקושי הרגיל של 'הנסיך' ב-Civ V הוא קצת קל מדי, בעוד שהשלב הבא עולה קשה מדי. במשחק Civ אידיאלי שבו הניצחון היה רק בהישג יד, המתח בין מתן יתרון לעצמי והגדלת הסבירות לאסון עולמי היה החלטה מעניינת - החלטה שיכולה מאוד להתקבל ביום מן הימים בעולם האמיתי.

זו דוגמה לאופן שבו המוד יכול היה להיות מדויק אבל בפועל הוא לא, אבל יש היבטים אחרים שלו שנכונים. אחד מאלה הוא הדרך שבה אתה מגיע לטכנולוגיה כדי לחקור בינה מלאכותית הרבה לפני שאתה מגיע לטכנולוגיה הנדרשת כדי להתחיל להפוך אותה לבטוחה, וזו נקודת מפתח שהועלתה לעתים קרובות על ידי תומכי בטיחות בינה מלאכותית. מדויקת היא גם הדרך שבה הציוויליזציה שמובילה את חקר הבינה המלאכותית שלה מבטיחה לראשונה ניצחון מוחלט: המירוץ לבניית מודיעין-על הוא תרחיש מנצח לוקח הכל, אלא אם מודיעין-על זה יתברר כבלתי נשלט.

כל זה טוב ויפה, אבל ההצלחות האלה מתערערות בגלל הכישלונות שלה. הבעיה המהדהדת כאן היא כיצד המוד אומר לך את הנקודה המדויקת שבה ה-AI ישתלט, כאשר חלק גדול מהסכנה בחיים האמיתיים נובע מאי הוודאות שלנו מתי זה יהפוך לאפשרות. אנחנו לא יודעים כמה זמן ייקח לנו ליצור את התנאים לבינה מלאכותית סופר-אינטליגנטית בטוחה, וזה הטיעון הכי חזק שאני מכיר בשבילנו להתחיל לעשות מה שאנחנו יכולים כמה שיותר מוקדם.

יש להודות, להשקיע במשחק כל עוד Civ ושהוא יסתיים פתאום בנקודה בלתי ידועה, לא נשמע שזה יהיה כיף גדול. אף על פי כן, זה עדיין המצב שאומר לך בדיוק מה נדרש כדי למנוע קטסטרופה מבוססת מודיעין על מייצג באופן לא מדויק את אחד המרכיבים המדאיגים ביותר של האיום. שינוי אופן פעולת המערכת אולי אינו הרעיון הטוב ביותר, אבל אני כן חושב שהמוד היה צריך למצוא דרך להכיר בחוסר הדיוק הזה.

ציפיתי גם שהמוד יתאמץ יותר כדי להסביר למה זה איום שכדאי לקחת ברצינות. יש כמה ציטוטים רלוונטיים כשאתה חוקר את הטכנולוגיות החדשות, אבל זה פחות או יותר הכל. הוספת 'יועץ בינה מלאכותית' כדי להחליף את המדע היה אידיאלי. זה מרגיש כמו הזדמנות מבוזבזת לקבל את הסיבות האמיתיות לדאגה לגבי AI מול אנשים - ואני לא רוצה שזה יהיה נכון לגבי המאמר הזה.

כן, הגיע הזמן לקורס מזורז בתורת AI. יהיה כיף, מבטיחה!

עם זאת, ראשית, ראוי לציין שמאות מאמרים (שנכתבו על ידי אנשים מעודכנים יותר ממני) נכתבו על הנושאים שאני הולך לעבור עליהם בכמה פסקאות, וחלקם מתנגדים לטענות שאני עומד להביא. לְמַעלָה. עם זאת, יש מספר גדל והולך של אנשים אינטליגנטים הרואים במחקר בטיחות בינה מלאכותית לטווח ארוך חשיבות עליונה כדי להבטיח את המשך קיומנו כמין - אז כדאי לשמוע אותם, אה?

לפני שנגיע לסכנות הפוטנציאליות של AI סופר אינטליגנטי, עלינו להבהיר אם זה בכלל אפשרי. אני אתייחס כאן לטיעון שסם האריס מעלהההרצאה המצוינת הזו ב-TED. הנה התמצית: אם נקבל שהאינטליגנציה היא עניין של עיבוד מידע, שבני אדם ימשיכו לשפר את יכולתן של מכונות לעבד מידע, ושבני אדם אינם קרובים לפסגת המודיעין האפשרי - אז במקום אירוע הכחדה, זה כמעט בלתי נמנע שנפתח צורה כלשהי של אינטליגנציה על.

נוכל לבזבז לנצח בחפירה בהנחות אלו, אבל בואו נעבור לסכנה שמודיעין כזה עלול להוות. מכון עתיד החיים מצליח להפריך תפיסה שגויה פופולרית ולחתוך ללב הסוגיה במשפט אחד:"הדאגה לגבי בינה מלאכותית מתקדמת היא לא רשעות אלא יכולת". בינה מלאכותית לא עומדת 'להפוך לרשע' או 'להתמרד', אבל יש סיבות טובות להאמין שהבטחת שהמטרות שלה באמת עולות בקנה אחד עם אלו של האנושות תהיה כרוכה במלכודות. זו בעיית יישור הערכים, וזה עניין גדול.

נייט סוארס, המנהל הבכיר של מכון המחקר למודיעין מכונה, עשה זאתההקדמה הטובה ביותר לבעיית היישורשנתקלתי בו. מאמר זה מדגיש כיצד מתן AI משימה בטוחה ופשוטה לכאורה יכולה להשתבש בצורה אסון. אם אתה מורה לבינה מלאכותית למלא קדירה במים, למשל, אתה יכול לקוות שהיא פשוט תישפך פנימה את המים יכול לקרוא לזה יום. מה שתשכחו הוא מה שסוארס מכנה "ההקשר ההסתברותי":

"אם המטאטא מקצה הסתברות של 99.9% ל"הקלחת מלאה", ויש לו משאבים נוספים מונחים בסביבה, אז הוא תמיד ינסה למצוא דרכים להשתמש במשאבים האלה כדי להעלות את ההסתברות אפילו קצת יותר".

זה מוביל אותנו למנהל מכון העתיד של האנושות, ניק בוסטרום, ושלותזה התכנסות אינסטרומנטלית. זה נשמע יותר מסובך ממה שזה, בכנות. הטענה אומרת שכמעט עם כל יעד קצה שאתה נותן ל-AI, ישנן מטרות אינסטרומנטליות מסוימות שהיא גם תרדוף אחריהם כדי להשיג את המטרה הסופית הזו.

אז עם מילוי הקדירה של סוארס, אחת הדרכים של ה-AI להגביר את הוודאות שלו שהקלחת התמלאה היא למקסם את האינטליגנציה שלו. איך זה יכול ללכת לעשות את זה? אולי על ידי הפיכת כל משאב שהוא יכול להשיג עליו לשבבי מחשב. חושבים שפשוט נוכל לכבות את זה? מטרה אינסטרומנטלית נוספת שהוצעה על ידי בוסטרום היא שימור עצמי, כך שלא סביר שזה יהיה כל כך קל (סוארס מפרט על בעיות עם "השעיית כפתורים”).

נכנסתי לכל כך הרבה פרטים כי א) אני חושב שזה חשוב ומרתק כאחד וב) ההתכנסות האינסטרומנטלית של בוסטרום נמצאת בבסיס האם המוד מציאותי או לא בתיאור דום כתרחיש ברירת המחדל. "האם ברירת המחדל של תוצאה היא אבדון?" היא למעשה כותרתו של פרק בספרו של בוסטרום על אינטליגנציה-על, וזו שאלה שאפילו הוא נרתע מלהגיב בחיוב בחיוב - אם כי זו התשובה שאליה מתבססים הטיעונים שלו.

עם זאת, יש להכיר בכך שעמדה זו רחוקה מלהיות הקונצנזוס המדעי. מייק קוק, הבחור מאחורבינה מלאכותית מייצרת משחקים אנג'לינה, כתב לאחרונה פוסט בבלוגשבו הוא טועןשהמוד "מרגיש פחות כמו מאמץ למודעות ציבורית ויותר כמו פעילות מיתוג למעבדה". הוא מעלה הרבה נקודות טובות, לא פחות מהן שה-CSER עשוי להרוויח מהגזמת האיום ולגרום לאנשים לדבר - אלא אם ההגזמה הזו תאבד את אמון האנשים בטווח הארוך.

באופן אישי, אני לא חושב שהמוד מגזים באיום של AI חכם יותר מאדם. אם כבר, היעדר הסבר מראש לגבי מדוע בטיחות בינה מלאכותית היא משהו שצריך להתייחס אליו ברצינות, יכול להוביל אנשים לבטל את הנושא. זו נקודה שמחזירה אותי לכמה שהמוד יכול היה להפיק תועלת מלכלול את אותו יועץ AI, שהיה יכול להעביר את הטיעונים המרכזיים בנקודות רלוונטיות.

רק אחרי שסיימתי את המשחק הבנתי שהמוד כולל ערכים מפורטים של Civlopedia עבור הטכנולוגיות והפלאים החדשים. זה אומר שהטיעונים המרכזיים האלה נמצאים במוד, אבל בלי שום דבר שיסב את תשומת לבכם ל-Civlopedia, אני חושש שרוב האנשים יתגעגעו אליהם בדיוק כפי שכמעט הרגשתי. אני אוהב את הרעיון מאחורי המוד, אבל אני לא משוכנע שהוא מצליח כמשהו שכיף לשחק בו או כמשהו ללמוד ממנו. רוב הבעיות שלי עם זה כמשחק הן בלתי פתירות, והן קשורות יותר ל-Civ עצמו מאשר למוד - אבל עם השינויים הנכונים, המוד עדיין יכול להיות כלי רב עוצמה להדגשה והסבר של הבעיות סביב בטיחות AI.

אם אתה רוצה לקרוא עוד על המוד, בדוקהראיון שלנו עם היוצר שלו.